Les trois principes fondamentaux de DevOps, appelés aussi les "Trois Voies" (Three Ways), sont les piliers de la culture DevOps. Ils ont été popularisés par Gene Kim dans le livre The Phoenix Project, puis approfondis dans The DevOps Handbook.

Ces principes forment une philosophie globale qui guide la conception des systèmes, des processus et des comportements dans une organisation DevOps.

⚙️ 1. La Première Voie : Le Flux (The First Way — Flow)

🎯 Objectif :

Accélérer la livraison de valeur du développement jusqu’à la production.

💡 En pratique :

-

Automatiser le pipeline de livraison (CI/CD)

-

Réduire les temps de cycle (cycle time)

-

Identifier et éliminer les goulots d’étranglement

-

Promouvoir la livraison fréquente et incrémentale

🧰 Outils et méthodes :

-

Intégration continue (CI)

-

Déploiement continu (CD)

-

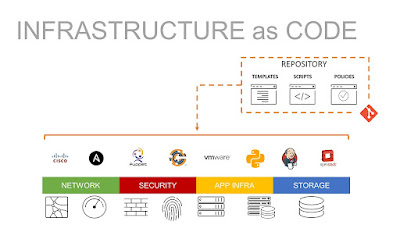

Infrastructure as Code (IaC)

-

Microservices et containers

🔄 2. La Deuxième Voie : Le Feedback (The Second Way — Feedback)

🎯 Objectif :

Créer des boucles de rétroaction rapides et continues à tous les niveaux du système.

💡 En pratique :

-

Détection rapide des erreurs

-

Remontée rapide des incidents depuis la production jusqu’au développement

-

Tests automatisés et surveillance active

-

Collaboration constante entre Dev, Ops, QA, Sécurité, Métier

🧰 Outils et méthodes :

-

Monitoring et alertes (Grafana, Prometheus…)

-

Analyse de logs centralisée (ELK, Datadog…)

-

Post-mortem sans blâme

-

Feedback utilisateurs intégré dans les sprints

📈 3. La Troisième Voie : L’Apprentissage et l’Amélioration Continue (The Third Way — Continual Learning & Experimentation)

🎯 Objectif :

Favoriser une culture d’amélioration continue, d’apprentissage permanent et d’innovation contrôlée.

💡 En pratique :

-

Apprendre de chaque incident (et documenter)

-

Encourager l’expérimentation (ex : tests A/B, déploiements canari)

-

Accepter l’échec comme moteur d’apprentissage

-

Automatiser les leçons apprises

🧰 Outils et méthodes :

-

Chaos Engineering (ex : Chaos Monkey)

-

Revue des incidents post-déploiement

-

Culture DevSecOps

-

Formations, hackathons, communautés de pratique

🧭 Résumé des Trois Voies DevOps

| Principe | But principal | Ce que cela change |

|---|---|---|

| 1. Le Flux | Livrer vite et souvent | Automatisation, petits lots, CI/CD |

| 2. Le Feedback | Détecter les erreurs tôt | Monitoring, alertes, feedbacks continus |

| 3. L’Apprentissage | S’améliorer sans cesse | Culture de test, sécurité, innovation |

🧠 Conclusion

Les trois voies de DevOps ne sont pas des étapes linéaires mais des pratiques interconnectées, essentielles à la transformation DevOps. Elles permettent de :

-

Réduire les risques de mise en production

-

Améliorer la collaboration Dev/Ops/Sécurité/Métier

-

Favoriser l’agilité, la stabilité et la rapidité

🌟 Si votre organisation ne suit pas ces 3 voies, elle risque de faire du « DevOps de façade » sans transformation réelle.

.jpg)